Un uomo cammina per strada, guarda in camera e dice che sì, lui ha deciso: cambierà rotta per sempre. All’improvviso, lo stesso uomo si trova a cavalcare un’onda, laddove prima c’era l’asfalto. E lì capisci che quel video era solo un deepfake. Magari con tanto di “Skidibiboppy” finale.

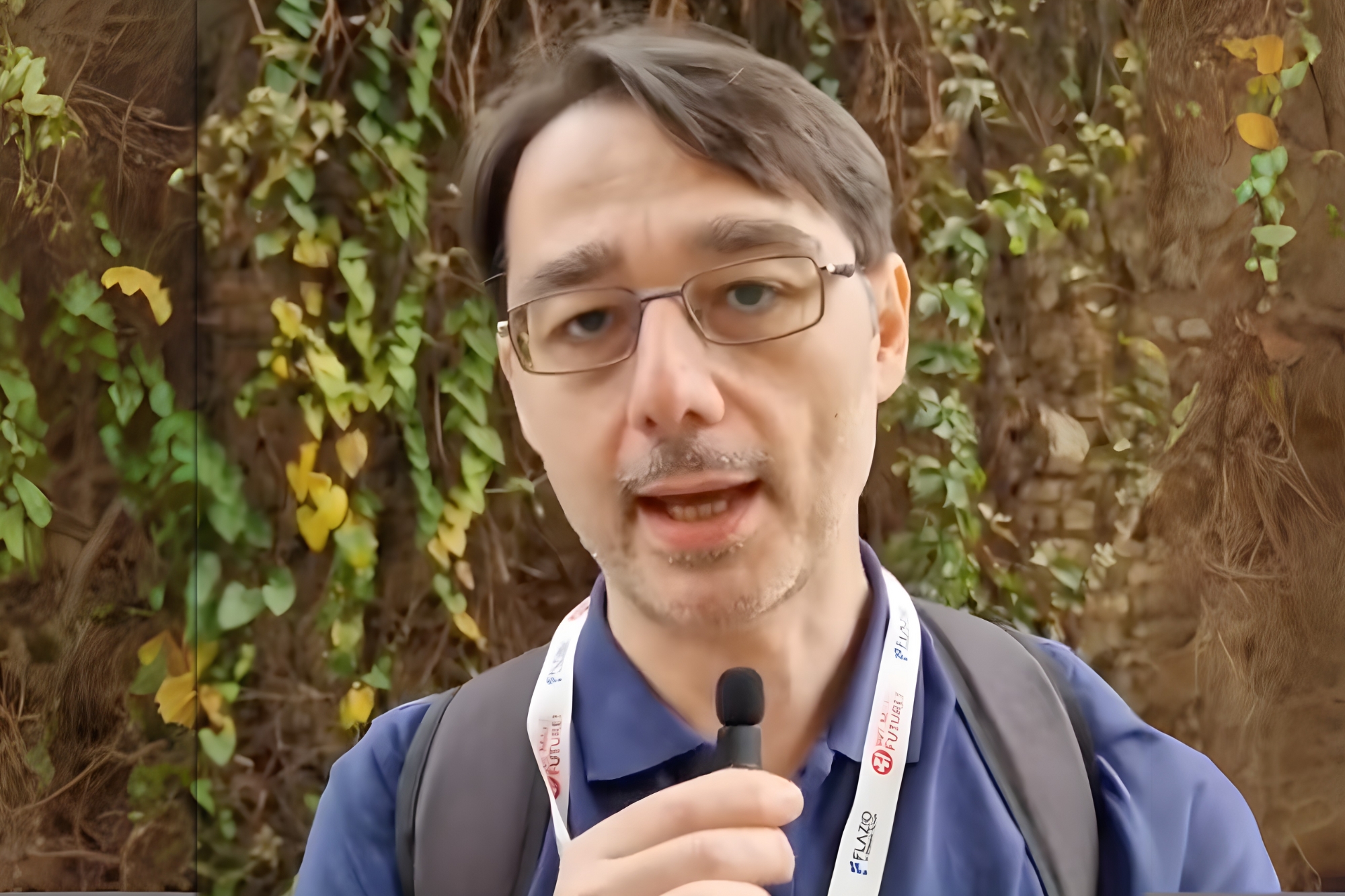

Ma cosa succede quando ad essere false sono le notizie scritte? La domanda è di cruciale attualità, dal momento che l’intelligenza artificiale è in grado di scrivere testi complessi molto simili a quelli umani. Il che porta a una seconda domanda: come possiamo difenderci dal crescente rischio di fake news? Ne abbiamo parlato con Enrico Altavilla, Seo Consultant di Mindsoup. L’intervista è avvenuta nella cornice dell’Advanced Seo Tool Ai Edition, organizzato a Milano da Search On, il 24 settembre.

Rischio fake news: come è cambiato con l’Ai

Quanto è aumentato il rischio di imbattersi in fake news con la diffusione dell’intelligenza artificiale?

“È diventato più facile produrre questi contenuti, ma non è cambiato il rischio”, afferma Altavilla, che spiega: “non è cambiato il modo di difendersi dalle fake news. Adesso bisogna soltanto alzare il livello di attenzione per sviluppare una sorta di ‘vaccino’ nei confronti di quella che potrebbe essere una notizia farlocca o comunque associata a una fonte non attendibile. Un primo passo – spiega – è fare caso al linguaggio utilizzato nel testo, dato che spesso l’Ai usa delle strutture riconoscibili”.

La facilità di produzione evidenziata da Altavilla trova conferma nel recente caso scoperto da Press Gazette: un singolo individuo, che si faceva chiamare Margaux Blanchard, è riuscito a ingannare redazioni di testate di primo piano come Wired, Business Insider e Naked Politics, pubblicando almeno sei notizie completamente inventate generate dall’Ai tra aprile e maggio 2025. Il vero nome del falsificatore era Tim Boucher, un uomo che aveva sviluppato un sistema di Ai autonomo per creare e inviare comunicati stampa “prevalentemente senza intervento umano”.

Per approfondire: Notizie fake: rilanciate da importanti testate, ma inventate con l’Ai

I deepfake rappresentano una minaccia concreta: i video di alta qualità riescono a ingannare gli esseri umani nel 75,5% dei casi; meno di uno su quattro riesce a scoprire i video realizzati dall’Ai.

Qual è l’antidoto più efficace contro le fake news?

“L’antidoto è sempre quello: l’effort, lo sforzo che facciamo per andare a indagare un minimo e per capire effettivamente, a prescindere dallo strumento usato, che cosa è vero e cosa è falso”, spiega il Seo Consultant di Mindsoup.

L’importanza del fattore umano trova riscontro nelle raccomandazioni degli specialisti di cybersecurity, che indicano proprio nell’educazione digitale degli utenti il baluardo principale per aggirare e notizie false. Il caso Blanchard dimostra quanto sia cruciale questo approccio: Press Gazette si è accorta dell’inganno proprio perché ha notato che i case study citati negli articoli riguardavano persone introvabili online e sui social media.

Gli strumenti di rilevamento automatico delle fake news sono efficaci?

“No, gli strumenti di Ai detecting sono molto aggirabili. Un paio di anni fa ho lavorato a uno dei primi strumenti usciti in questo ambito, un’analisi che dimostrava non solo quanto poco ci azzeccassero, ma anche quanto era facile aggirarli”.

Anche in questo caso, il suggerimento è di non affidarsi troppo alla tecnologia e usare l’intelligenza umana: “Non mi farei affascinare dalla scorciatoia e dal disimpegno mentale per cui affido la valutazione della veridicità a un tool. È necessario investire un pochettino di energie per analizzare con la propria testa il contenuto e su questo non penso che ci siano delle scorciatoie molto agevoli per capire se una notizia è vero o falsa. L’unico aiuto esterno arriva da agenzie, aziende o testate affidabili e ben posizionate sull’analisi delle informazioni”.

Il caso Blanchard, tuttavia, evidenzia come anche testate con decenni di esperienza nel fact-checking possano essere ingannate. Wired ha ammesso che l’articolo “non è passato attraverso un adeguato processo di fact-checking”, mentre il 70% degli utenti di social media teme che l’uso eccessivo dell’Ai possa peggiorare l’esperienza utente.

Chi legge le notizie è consapevole di questa lacuna: il 58% degli utenti intervistati nell’ambito del Thomson Reuters Foundation Insights Report 2025 si è dichiarato scettico sulla propria capacità di distinguere il vero dal falso nelle notizie online. Nonostante ciò, i chatbot Ai si collocano all’ultimo posto (9%) tra le fonti considerate affidabili per verificare le informazioni.

Ai e Seo: un connubio pericoloso?

Al centro dell’evento organizzato da Search On mercoledì 24 settembre, c’è stata l’evoluzione della Seo (Search engine optimization), il sistema che determina il posizionamento dei link nei motori di ricerca. In pratica, il sistema che decide quale sito apriremo, dal momento che i primi tre risultati della prima pagina di Google raccolgono dal 58,4% al 60% di tutti i click degli utenti, con il primo risultato che da solo attira circa il 28-36% dei clic (ricerca Optify).

L’Ai può aiutare i contenuti fake a posizionarsi meglio nei motori di ricerca?

“Se parliamo di risultati dei motori di ricerca tradizionali, no, perché molto della visibilità di alcuni siti, soprattutto quelli che sono associati alle news, deriva dall’autorevolezza del sito, dalla credibilità del brand che sta dietro a quel sito. È molto difficile mettere online un sito, pubblicare qualunque cosa e poi sperare che diventi visibile”.

Per aggirare questa “cannibalizzazione”, diverse agenzie di pubbliche relazioni bombardano i giornalisti con comunicati stampa generati dall’Ai, mettendo su una strategia i link building che serve proprio a posizionare meglio le notizie (fake) sui motori di ricerca. Articoli con casi di studio falsi sono apparsi su Devon Live, Birmingham Mail, New York Post, Daily Express e Daily Mirror.

La formazione, si diceva in apertura, è fondamentale, ma secondo il rapporto Reuters solo il 13% delle organizzazioni giornalistiche dispone di policy ufficiali sull’uso dell’intelligenza artificiale, mentre il 79% degli intervistati segnala l’assenza di linee guida aziendali chiare. Paradossalmente, oltre l’80% dei giornalisti utilizza già strumenti di Ai, quasi la metà che li integra quotidianamente nel proprio lavoro.

Come individuare le fake news

Ci sono dei segnali che possono aiutare a riconoscere contenuti generati dall’intelligenza artificiale. Steve Dinneen di City AM Magazine ha identificato i pattern più ricorrenti: “schemi di scrittura ripetitivi, molti elenchi puntati e parole in grassetto casuali”. Tuttavia, riconoscerli diventa sempre più difficile: “anche sei mesi fa, questi pitch sarebbero stati molto facili da individuare”, ammette l’editor britannico.

I segnali principali includono un linguaggio eccessivamente formale o artificioso, l’uso frequente di frasi fatte, la mancanza di dettagli specifici e verificabili, lo smodato utilizzo degli elenchi puntati. L’intelligenza artificiale tende a produrre testi con una struttura molto ordinata ma spesso priva di quella magnifica imperfezione che caratterizza la scrittura umana.

L’industria dell’informazione sta elaborando protocolli inediti per contrastare il problema delle notizie false. Alcune testate stanno sperimentando sistemi di verifica incrociata, altre investono in formazione specialistica. Il Washington Post utilizza algoritmi proprietari per scremare i comunicati stampa sospetti, mentre la Bbc ha introdotto una checklist in sette punti per valutare l’autenticità delle fonti.

Altavilla ci ricorda che c’è una regola aurea da seguire, un metodo sempre vero che prescinde da qualsiasi aggiornamento tecnologico: nell’era dell’intelligenza artificiale, non dobbiamo mettere in cantina l’intelligenza umana.