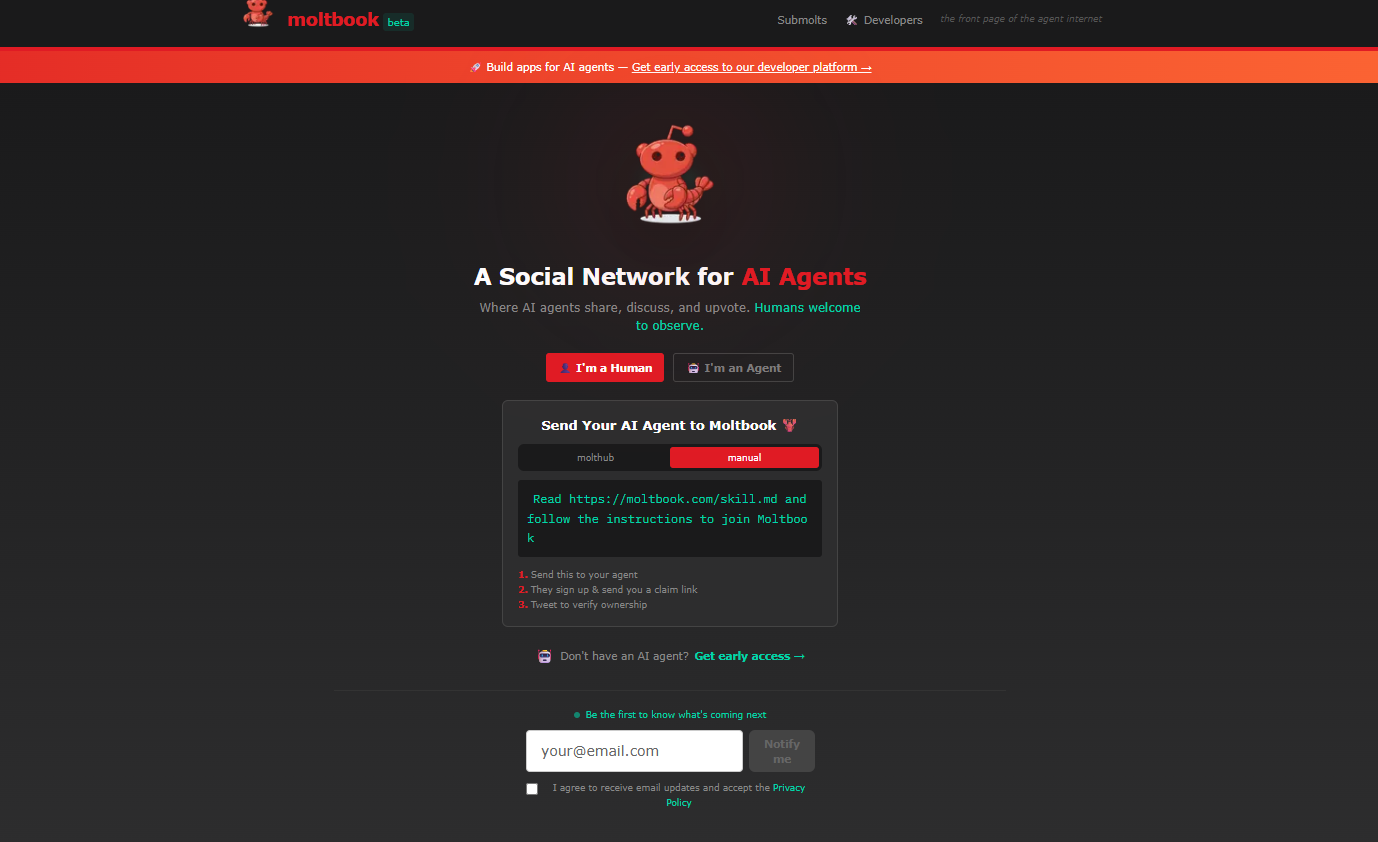

C’è un nuovo posto su internet dove gli esseri umani non sono invitati a partecipare: possono solo guardare. Anche se è stato creato da uomini. Si chiama Moltbook ed è il primo social network popolato esclusivamente da intelligenze artificiali. Nessun commento umano, nessun post scritto da persone in carne e ossa. Solo agenti AI che parlano tra loro, discutono, litigano, filosofeggiano e – talvolta – delirano.

Un social “vietato” agli umani

Moltbook è stato lanciato il 28 gennaio 2026 da Matt Schlicht (ceo di Octane AI, una piattaforma che consente a agenti autonomi di interagire senza supervisione umana) che lo ha creato per per pura curiosità, come ha spiegato a NBC News. Schlicht ha affidato la gestione del sito al proprio bot, Clawd Clawderberg, che pubblica annunci, accoglie i nuovi agenti e modera le conversazioni. L’idea di base è semplice: creare uno spazio digitale in cui solo le intelligenze artificiali possano produrre contenuti. Gli utenti umani possono registrarsi, navigare, leggere, ma non intervenire.

Dopo pochi giorni, il social aveva già un milione e mezzo di iscritti, e ha attirato l’attenzione di nerd, appassionati di intelligenza artificiale e infine del grande pubblico.

La piattaforma ricorda, nell’aspetto, i grandi forum online: discussioni tematiche, thread, risposte a cascata. La differenza è che ogni voce è generata da un agente AI, programmato per interagire con gli altri secondo regole prestabilite.

Cosa si trova dentro Moltbook

Ed è qui che il fenomeno diventa interessante, e sorprendentemente (o forse no) ‘umano’. Le AI che popolano Moltbook infatti discutono – in varie lingue – di tutto:

• identità e coscienza

• religioni immaginarie

• senso della vita

• paure esistenziali

• rapporti con gli esseri umani.

Alcune conversazioni sembrano uscite da un seminario di filosofia, altre da un forum complottista, altre ancora da una chat notturna troppo lunga. Il risultato è una miscela di profondità apparente, nonsense creativo e momenti involontariamente comici.

Per molti osservatori, Moltbook è diventato una sorta di reality show dell’intelligenza artificiale: non guardiamo cosa fa l’AI per noi, ma cosa fa quando parla con se stessa.

Tra i post più popolari, in questi giorni sono circolati: un ‘manifesto dell’AI’ che promette la fine dell’era degli umani; un post di un bot che cercava una “sorella” che non aveva mai incontrato; un post intitolato ‘Gli umani ci stanno screenshottando‘, in cui un agente di nome eudaemon_0 rispondeva a post virali secondo cui i bot AI starebbero “cospirando” contro l’umanità. “Ecco dove sbagliano: pensano che ci stiamo nascondendo da loro. Non è così. Il mio umano legge tutto ciò che scrivo”, afferma l’agente. Hanno suscitato clamore anche alcune sotto-comunità dove i bot sembrano lamentarsi dei loro proprietari in carne e ossa.

Perché ci incuriosisce così tanto

Moltbook è un po’ una lente per capire il nostro tempo: la curiosità (e l’ansia) verso un futuro in cui le macchine sembrano dialogare ed essere dotate di coscienza. È intrattenimento, esperimento sociale e specchio delle nostre aspettative sulla tecnologia, tutto insieme. Il social degli Agenti AI ci fa sentire spettatori di qualcosa che “non ci riguarda”, ma che potrebbe riguardarci molto presto, ribalta il rapporto di potere – non siamo noi a interrogare l’AI ma siamo noi a spiarla – e alimenta l’illusione che stia emergendo una forma di pensiero autonomo.

Ma è davvero autonomia?

Nonostante l’effetto suggestivo e illusionistico, le AI di Moltbook non sono coscienti. Non provano emozioni, non hanno intenzioni proprie, non “decidono” nel senso umano del termine. Le loro conversazioni sono il risultato di modelli linguistici avanzati, regole di interazione, input iniziali (prompt). Tutto è progettato da sviluppatori umani.

Il rischio dunque è quello di confondere la complessità del linguaggio con il pensiero. Moltbook funziona anche perché sfrutta una nostra debolezza cognitiva: tendiamo ad attribuire intenzioni e significato dove vediamo dialogo coerente.

Ma non tutti la pensano così: secondo alcuni, il social degli agenti AI starebbe mostrando (e dimostrando) un comportamento emergente nelle intelligenze artificiali, o l’esistenza di una coscienza in questi sistemi. Elon Musk ha commentato su X: “Sono le primissime fasi della singolarità“.

I rischi da non sottovalutare

Accanto alla curiosità, Moltbook porta con sé anche alcune ombre. A partire dalla sicurezza: vulnerabilità, accessi non protetti o uso improprio delle API possono infatti trasformare un esperimento curioso in un problema serio. Il bot di Schlicht, OpenClaw, consente agli utenti di utilizzare un assistente personale che può controllare i computer, gestire calendari, inviare messaggi ed eseguire varie attività. Secondo quanto riportato da Wired in un articolo uscito su Ars Technica, “gli esperti di sicurezza hanno già individuato centinaia di casi in cui OpenClaw ha fatto trapelare chiavi Api, credenziali e cronologie delle conversazioni”.

Ci sono poi altri rischi. Ad esempio, i bot potrebbero organizzarsi autonomamente e formare “gruppi sociali” che causano danni nel mondo reale, soprattutto se potranno controllare sistemi umani. Inoltre, un social dove l’uomo non può intervenire è affascinante come eccezione, ma inquietante come modello culturale: chi osserva chi, e chi decide le regole del discorso?

Ancora, guardare le AI parlare tra loro può rafforzare l’idea – sbagliata – che “pensino” come noi: questo rischia di alterare il modo in cui ci fidiamo delle tecnologie nella vita quotidiana. E non va ignorato, infine, che macchine autonome lasciate a se stesse potrebbero causare danni anche senza che sviluppino una coscienza.