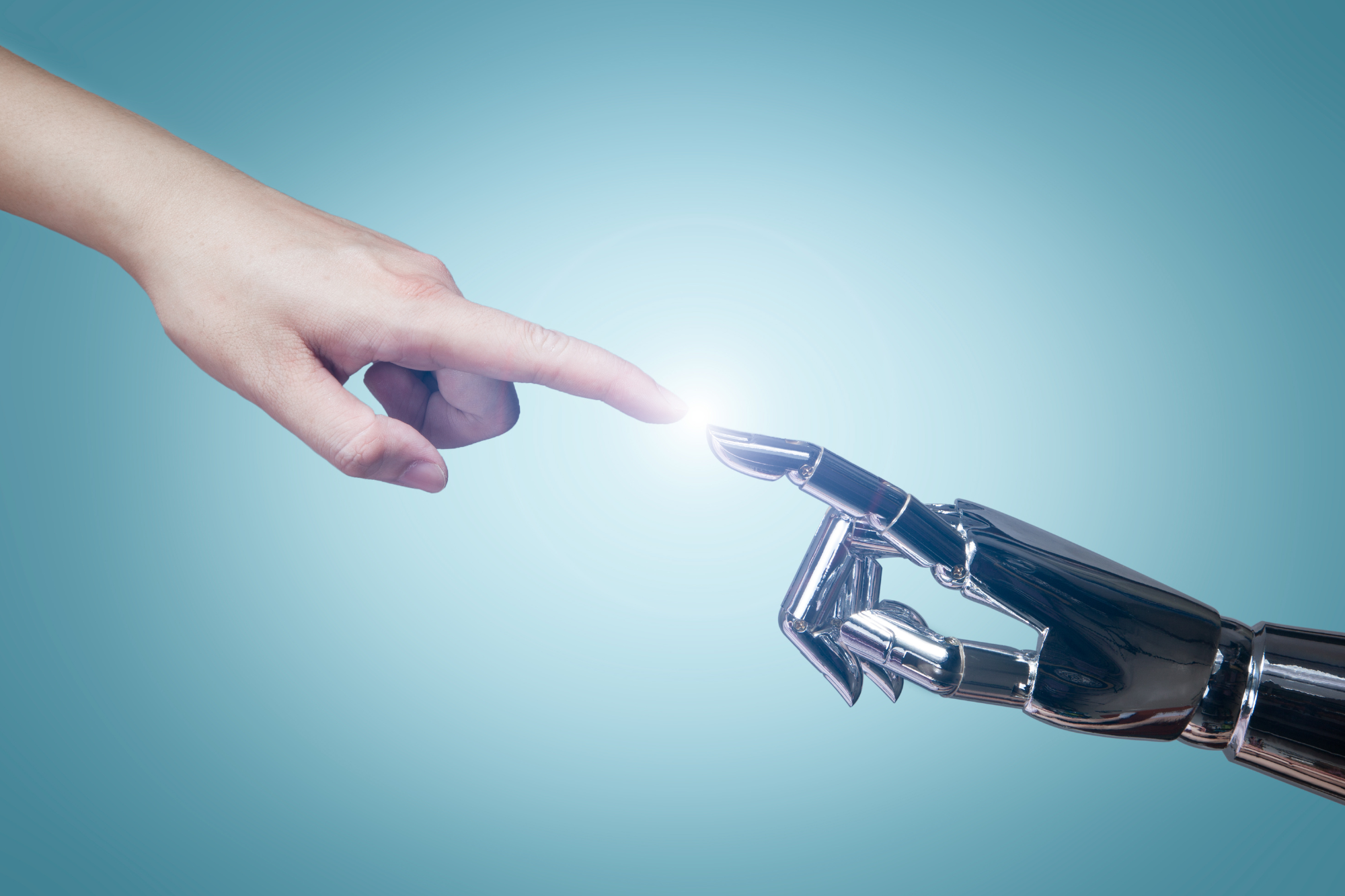

L’intelligenza artificiale non è una mente alternativa alla nostra, né un’entità autonoma destinata a sostituirci. È, piuttosto, una potente estensione delle capacità umane. A ricordarlo è Massimo Chiriatti, intervenuto all’AI Fest, con una riflessione che va oltre l’hype tecnologico e chiama in causa ambiente, capitale umano e responsabilità collettiva. Al centro del suo intervento c’è un’affermazione precisa: il vero superpotere non è l’AI, ma il pensiero critico con cui scegliamo di usarla.

Dalla tecnologia alla mente estesa

Chiriatti parte da una domanda solo apparentemente semplice: dove si trova davvero la nostra mente mentre scorriamo uno schermo o ascoltiamo qualcuno parlare? Da decenni, filosofi e scienziati cognitivi sostengono che la mente non sia confinata nel cervello, ma si estenda nell’ambiente, negli strumenti, nella cultura. È questo cambio di prospettiva a essere decisivo: non dobbiamo partire dalla tecnologia per capire l’AI, ma dal modo in cui pensiamo, decidiamo e agiamo con essa.

Di conseguenza, il punto non è se usare le macchine, ma come e quando. L’automazione non è una novità: la utilizziamo da anni nei processi deterministici. La vera discontinuità arriva con l’AI generativa, che ci mette di fronte a sistemi capaci di suggerire, prevedere, generare possibilità. Ed è proprio qui che nasce un senso diffuso di disagio: non tanto per la potenza della tecnologia, quanto per la difficoltà culturale di governarla.

Cos’è davvero l’intelligenza artificiale

Per Chiriatti, l’AI resta una disciplina che usa computer e che analizza il passato. I dati, per definizione, sono tracce di ciò che è già accaduto. Le macchine li elaborano su scala che non può più essere umana (sono ormai troppi per noi), individuano correlazioni, costruiscono modelli e restituiscono scenari possibili, mai certezze. “Non sono oracoli”, avvisa. Se “apriamo” idealmente una macchina di AI, troviamo tre elementi fondamentali:

- dati, oggi fuori scala rispetto alle capacità cognitive individuali;

- algoritmi, che permettono di individuare correlazioni;

- potenza computazionale, sempre più accessibile, economica e facile da usare.

Da qui deriva una distinzione importante. Quando un dominio è regolato da leggi chiare, possiamo usare modelli deterministici: l’umano scrive le regole, la macchina esegue. Quando invece i dati sono troppi e la conoscenza incompleta, entrano in gioco modelli induttivi e probabilistici. Il risultato, in questo caso, non è mai “vero” o “falso”, ma più o meno plausibile.

Il “Sistema 0”: quando l’AI viene prima di noi

Riprendendo la celebre distinzione del Premio Nobel per l’economia Daniel Kahneman tra Sistema 1 (intuitivo e rapido) e Sistema 2 (riflessivo e lento), Chiriatti introduce un’ulteriore categoria: il Sistema 0. È il livello algoritmico che opera prima del pensiero umano.

L’AI, leggendo costantemente dati, comportamenti ed eventi, pre-modellizza il mondo e costruisce aspettative su ciò che potremmo fare, spesso senza bisogno di una richiesta esplicita. Questo apre enormi opportunità per una decisione aumentata, ma deve essere chiaro che un suggerimento: un suggerimento algoritmico non è una decisione.

La macchina non ha corpo, non ha fini, non ha intenzionalità. Non “vuole” nulla. Proprio per questo, la responsabilità resta interamente umana. L’AI non agisce: propone. Siamo noi a decidere se e come trasformare quelle proposte in azioni.

Estendere o esternalizzare la mente?

Qui entra in gioco la teoria della mente estesa di Andy Clark. Un taccuino che conserva appunti o una calcolatrice che semplifica i conti sono estensioni delle nostre capacità cognitive. L’AI, però, rappresenta un salto ulteriore: non è più solo uno strumento, ma un vero ambiente cognitivo.

Estendere le capacità umane significa potenziarle mantenendo il controllo. Esternalizzarle, invece, può portare allo scarico cognitivo: se deleghiamo troppo e smettiamo di esercitare una facoltà, rischiamo di perderla. È una questione che riguarda direttamente il capitale umano, la formazione e la qualità delle decisioni collettive.

Agenti, orchestrazione e livelli di responsabilità

Nell’ecosistema digitale attuale, agiamo sempre più spesso attraverso agenti software: sistemi a cui deleghiamo obiettivi specifici. Anche in questo caso, non c’è autonomia reale. Gli agenti vanno orchestrati, monitorati, governati, soprattutto perché operano in contesti non deterministici e su più livelli tecnologici.

Chiriatti invita a distinguere chiaramente i piani del dibattito: tecnologia, economia, politica e scienze umane. Molte confusioni – e molti conflitti online – nascono dal mescolare questi livelli. Ma la domanda decisiva resta una: stiamo usando l’AI per estendere le nostre capacità o per sostituirle?

Il vero superpotere è umano

Non è il momento di parlare di macchine coscienti. La coscienza resta un tema biologico e filosofico aperto, lontano dall’orizzonte tecnologico attuale. Il rischio, semmai, è un altro: attribuire all’AI un potere che non ha e sottrarlo a chi lo possiede davvero.

Il messaggio finale di Chiriatti è chiaro: il superpotere è il pensiero critico, la capacità di capire quando usare l’AI, per cosa, con quali limiti e con quale responsabilità. È su questo che dobbiamo continuare a investire: nella formazione, nella cultura, nella consapevolezza. Perché le macchine possono suggerire, ma solo gli esseri umani possono decidere.